Нейросети, которые еще год назад были чем-то загадочным и в целом не совсем понятным для простого пользователя, сегодня серьезно вошли в интернет-бизнес. Ими активно пользуются блогеры и даже крупные сайты, генерируя уникальные тексты и картинки для своих нужд.

Казалось бы, сиди и делай сайты на любую тематику – только оплати доступ на месяц в ChatGPT. При должной доле усердия за месяц можно состряпать целую сеть порталов, которые, вероятно, могут приносить прибыль. Однако компании продолжают нанимать на работу вполне себе живых авторов и редакторов, отказываясь от помощи ИИ, да и блогеры уже не так активно кричат из каждого рилса, что нейросеть сделает за тебя все. Почему? Потому что это не совсем так.

По роду деятельности мне много приходится работать с текстами: самой писать, редактировать, корректировать. Увидев впервые, как ChatGPT создает за 5 секунд то, на что у меня уходит 20 минут, я слегка остолбенела – вот это круто. Но впоследствии, присмотревшись внимательно, поняла, что пока ему будет довольно сложно заменить настоящего живого автора. Да и отличить статью, написанную ИИ, можно, если постараться. Как? Давайте разбираться.

1. Робот – это алгоритм

Да, все просто. У нейросети хоть и есть интеллект, но он искусственный. При этом оперирует она тем количеством данных, которые в нее загружены. Нейросеть может составить красивый текст на общую тему, но если дело касается анализа обстановки или ситуации, происходящей прямо сейчас, то, вероятнее всего, вы обнаружите явные несостыковки. Поэтому, если в тексте вы видите подобные ошибки в фактах, велика вероятность, что он полностью или частично составлен ИИ.

Ответ от ChatGPT

2. Ничего не понимаю

Иногда, если вы задаете вопрос текстовой нейросети о том, в чем у нее мало опыта или данных, полученный ответ будет довольно сумбурным и нелогичным. Выглядит это примерно так: слова вам знакомы и, вроде бы, даже расставлены в правильном порядке, но их комбинация вам ни о чем толком не говорит – ответ больше запутывает. Поэтому, если в тексте вы замечаете странности или совершенно нелогичные обороты, то его вполне мог составить искусственный интеллект. Пример:

Для ChatGPT такой формат – уже достаточно поверхностный, нейросеть быстро обучается. Но даже здесь видно, что ответ достаточно сумбурный.

3. Грамматические ошибки и странные конструкции

Некоторые нейросети имеют трудности с корректным написанием текста по правилам языка, на котором получили вопрос. Если вы замечаете в статье специфичные грамматические формы или своеобразные конструкции из слов, когда хочется сказать: «так же не говорят» – это вполне может быть признаком использования алгоритмов ИИ. Особенно это видно, если вы давно читаете конкретного автора и знаете его стиль и слог.

Подозреваю, что тут должны были быть «потоки капитала».

4. Как по шаблону

Нередко нейросети имеют тенденцию повторять одни и те же фразы в тексте. Происходит это потому, что эту тематику ИИ изучал на данных, составленных по одному шаблону. Он может попытаться сформулировать их иначе, но вы заметите, что как будто читаете одинаковый текст.

Люди редко так говорят, даже когда нервничают. А уж профессиональные авторы знают, как некрасиво выглядят повторы, если находятся рядом друг с другом, поэтому стараются их избегать. Множество похожих фраз и шаблонных выражений могут указывать на использование автором нейросети.

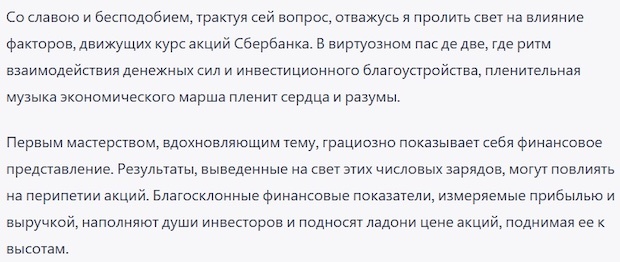

Вот, например, ответ ChatGPT на вопрос «Что влияет на курс акций Apple?»:

А это ответ ChatGPT на вопрос «Что влияет на курс акций Сбербанка?»:

В ответах явно повторяются некоторые пункты. Как говорится, найдите разницу.

5. Стилистические метаморфозы

Нейросети вполне могут имитировать различные стили написания текста: от литературного до максимально официального. Поэтому, если вдруг текст своим продолжением или кусочком начинает выбиваться из общего привычного ритма конкретного автора, это может быть признаком участия ИИ в его написании.

Для примера я попросила ChatGPT ответить на вопрос о том, что влияет на курс акций Сбербанка в литературном стиле. Он постарался:

6. Глубина смысла

Важно еще обратить внимание на тему текста, учитывая аудиторию, для которой его писали. Статьи от нейросети будут очень поверхностными, без личного опыта и примеров. А вот если речь идет о каких-то непростых или спорных вопросах, где видно субъективное мнение автора, то его вряд ли писала машина. Наверное, поэтому крупные порталы продолжают искать авторов со своим мнением – их статьи будоражат умы и сподвигают на размышления.

Зато честно!

Нейросеть ИИ видит издалека

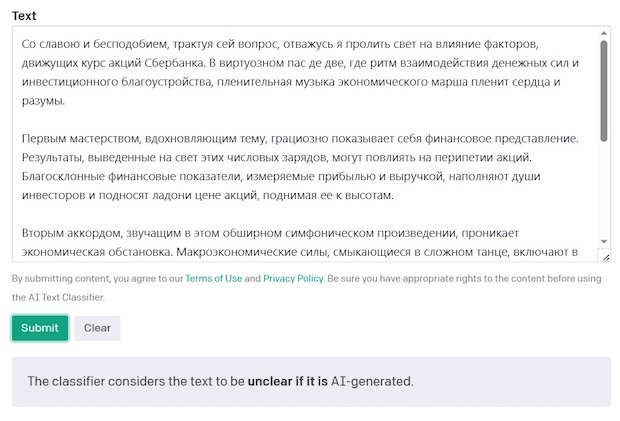

Если уж совсем сложно определить, является ли текст сгенерированным автоматически или написанным вручную, ChatGPT готов помочь. В начале 2023 года компания OpenAI предложила пользователям попробовать свой новый продукт AI Text Classifier, который работает по принципу анализа предложенного фрагмента с базой данных уже сгенерированных нейросетью текстов.

Как и в случае с «ручной» проверкой, AI Text Classifier не даст вам на 100% точный ответ о том, кем написан присланный текст: лишь в 26% случаях он определяет авторство нейросети точно. Если в текст были внесены небольшие правки и его «очеловечили», то сервис, вероятнее всего, этого не поймет. Также авторы признаются, что лучше всего классификатор работает с английскими статьями, написанными взрослыми людьми. Это тоже накладывает свои ограничения.

Тем не менее наш занимательный текст в литературном стиле из примера выше сервис успешно определил как, вероятнее всего, сгенерированный:

Заключение

Нейросети – довольно полезная штука даже для профессионального автора. Если задавать правильные вопросы, можно получить хорошую выжимку из массы информации, необходимой для написания нужного материала. Но брать тексты, сгенерированные машиной, целиком точно не стоит – со временем проверкой на ИИ обзаведутся все поисковые машины, и наличие на сайтах и в блогах таких материалов будет, скорее всего, большим минусом.

И забавный факт напоследок: Чарли Брукер, сценарист сериала «Черное зеркало», главная тема которого – влияние информационных технологий на людей, для интереса попросил ChatGPT написать сюжет для одного из эпизодов шоу. Результат поначалу показался ему вполне складным, но перечитав, он понял, что полученный текст оказался лишь обычной компиляцией синопсисов к уже существующим сериям «Черного зеркала». Брукер не увидел в полученном тексте ни одной оригинальной мысли и фантазии, только пародию. Однако он все-таки посчитал сгенерированные тексты полезными: их можно использовать как антипример – то, чего ему самому как сценаристу стоит избегать.

Читайте также:

А надо?

ДА надо, сейчас копирайтеры заспамили темы ,а ИИ спамить будет в 1000раз эффективнее, быстрее и дешевле. И поиск полезной и применимой инфы будет очень сложен.

Хотя бы этот ресурс. После массированного вливания копирайта интерес к нему падает. К Сергею Среднему на страничку зайдите, там график посетителей, на этом графике можно найти точку вхождения копирайтеров на портал и оценить ущерб.

Думаю, что "отличить текст" - это не беда. Беда с верификацией текста, с проверкой источников и истинности.

А этот вопрос уже не актуален.

Никто не будет об этом задумываться. Два простых примера (кейса - перевожу специально для журналистов, чтоб они поняли о чём речь), если их соединить, то будет понятно, какое будущее (кейс - специально для бизнес-консультантов) нас ждёт. Или вариант (кейс - для плодовитых авторов) будущего. Плохо, что к такому сценарию (кейсу - для редакторов) не готов никто в мире.

Ещё 10-15 лет назад мы ездили за рулём, зная маршрут (кейс), зная свой город. Менялись развязки, но мы не видели в этом проблем (кейсов). Сейчас все с навигаторами. Мы почти не задумываемся, верить ему, или нет. Ну уж если не совсем глупое "Найден более короткий маршрут". Нам называют адрес и мы едем, полностью доверившись навигатору. Даже не задумываясь, он нас ведёт к другу на имянины, или к банде вымогателей. Это первый пример (кейс). Заметили - мы даже не задумываемся?

Второй пример. Есть некая страна. Всего лишь целенаправленнная пропаганда, ежедневное вливание в головы определённых мысли полностью переформатировали народ. Полностью! Каждый из вас может вставить в этот пример свои детали, название страны неважно.

Не всякий ИИ способен стать "навигатором", но 90 процентов людей может поверить в любую чушь (кейс). Дети уже совершенно привычно верят Алисе. А если она "поумнеет" в тысячу раз?

О да, нейросети сейчас в диком тренде, но нормально пользоваться ими умеют не все. Как инструмент для ускорения рабочего процесса - вполне хорошая штука, сами пользуемся на работе периодически

ну дак, Вы его можете с клавиатуры набрать... Бог с ним, с изображением....

А вообще исследователи обеспокоены.

https://venturebeat.com/ai/the-ai-feedback-loop-researchers-warn-of-model-collapse-as-ai-trains-on-ai-generated-content

Группа исследователей пришла к выводу, что "обучение на данных, полученных другими моделями, вызывает коллапс моделей - дегенеративный процесс, при котором со временем модели забывают истинное базовое распределение данных ... этот процесс неизбежен даже в идеальных случаях для долговременного обучения".

"Со временем ошибки в сгенерированных данных соединяются и, в конечном счете, заставляют модели, которые учатся у сгенерированных данных, еще больше неправильно воспринимать реальность", - написал один из ведущих авторов статьи Илья Шумаилов в электронном письме VentureBeat. "Мы были удивлены, увидев, как быстро происходит коллапс модели: модели могут быстро забыть большинство исходных данных, из которых они изначально узнали".

Иными словами: поскольку модель обучения ИИ подвергается большему количеству данных, генерируемых ИИ, со временем она работает хуже, вызывая больше ошибок в реакциях и контенте, который она генерирует, и производя гораздо меньше неошибочного разнообразия в своих ответах.

Другой из авторов статьи, Росс Андерсон, профессор кибербезопасности в Кембриджском и Эдинбургском университетах, написал в блоге, обсуждая статью: «Так же, как мы разбросали океаны пластиковым мусором и наполнили атмосферу углекислым газом, мы собираемся заполнить Интернет бла-бла-бла. Это затруднит обучение новых моделей, очищая сеть, предоставляя преимущество фирмам, которые уже сделали это или которые контролируют доступ к человеческим интерфейсам в масштабе. Действительно, мы уже видим, как AI-стартапы забивают интернет-архив для получения учебных данных".

Тед Чан, известный автор научной фантастики «История вашей жизни», повести, которая вдохновила фильм «Прибытие», и писатель Microsoft, недавно опубликовал статью в The New Yorker, постулирующую, что копии ИИ-копий приведут к ухудшению качества, сравнив проблему с увеличенными артефактами, видимыми при повторной копии изображения.

Источник Insider info